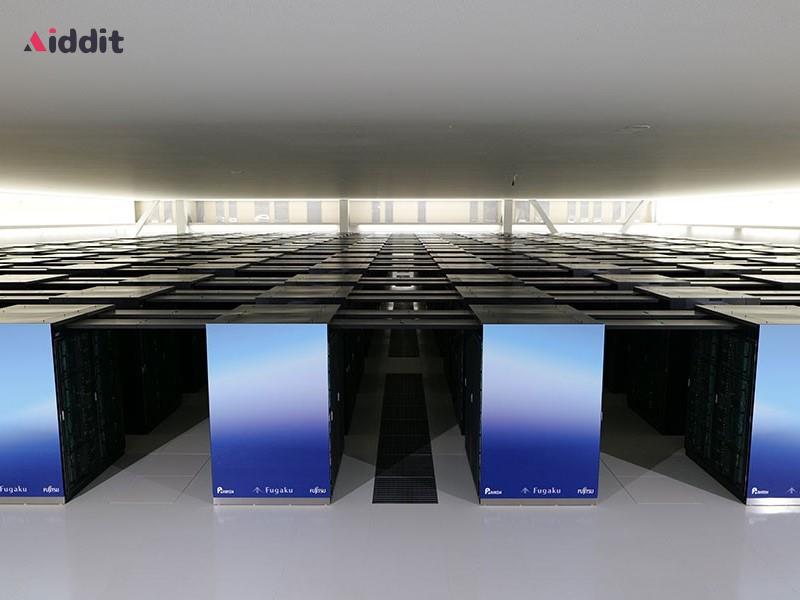

5月11日报道,日本一个由多家企业和机构组成的联合研究团队昨日推出了Fugaku-LLM大型模型。该模型最大的特点是使用Arm架构超级计算机“富岳”进行训练。

Fugaku-LLM 模型的开发始于2023年5月,最初的合作伙伴包括富士通、东京工业大学、日本东北大学和日本理化学研究所(理研)。

2023年8月,另外三家合作伙伴加入了该模型研发计划,它们分别是名古屋大学、CyberAgent(也是游戏公司Cygames的母公司)和HPC-AI领域初创企业Kotoba Technologies。

在最新发布的新闻稿中,研究小组宣称他们充分发挥了富岳超级计算机的性能,成功将矩阵乘法的计算速度提高了6倍,同时通信速度也提升了3倍。证实大规模纯 CPU 超级计算机也能够用于大型模型的训练。。

Fugaku-LLM 模型的参数规模为 13亿。它是日本国内最大规模的语言模型。

它利用了13824个富岳超算节点对3800亿个Token进行训练。在其训练数据中,60%为日语,剩下的40%包括英语、数学、代码等其他部分。

据该模型的研究团队表示,Fugaku-LLM 模型能够在对话过程中自然地运用日语的敬语等特殊表达方式。

就考试成绩而言,这个模型在日语 MT-Bench 模型标准测试中的平均分是5.5,在基于日本语料资源的开放模型中排名第一,在人文社科类别中获得了9.18的高分。

Fugaku-LLM模型目前已在GitHub和Hugging Face平台上公开,遵循许可协议的情况下,外部研究人员和工程师可以将该模型用于学术和商业用途。