GPT-4o是OpenAI最新推出的人工智能模型,具备强大的多模态推理能力,可处理语音、文本和视觉信息。此模型可实时响应用户输入,并在音频交互中检测和表达情感,提供更自然和富有表现力的交流体验。设计上着重提高运算速度和降低成本,速度是之前模型的两倍,成本仅为一半。GPT-4o在多语言处理、音频和视觉理解方面表现卓越,同时在安全性设计上进行强化,以确保交互的安全。目前,该模型的文本和图像功能已在ChatGPT中逐步推出,用户可免费体验,待后续推出音频和视频功能。

GPT-4o的主要功

多模态互动:GPT-4o不仅可以处理文本,还可以处理语音和视觉信息,能够理解和回应更广泛的用户输入,包括实时视频分析。

即时对话反馈:这个模型可以立即做出回应,不管是在文字对话、语音互动还是视频内容分析中,都可以迅速做出反馈。对于音频输入的响应时间非常短,平均为320毫秒,接近人类对话反应时间。

情感识别和模拟:GPT-4o可以辨识用户的情感状态,并在语音输出中模拟对应的情感,从而让对话更贴近人际间的自然交流。

编程辅助工具:GPT-4o可分析与理解编程语言中的代码片段,以助用户了解代码的用途与逻辑。用户可用语音向GPT-4o询问代码相关问题,模型将以语音回答,解释代码的运行原理或指出潜在问题。

多语言支持:GPT-4o能够覆盖超过50种语言,可以满足全球各地用户的需求。除此之外,它还支持多语言实时同声传译,比如将英语翻译成意大利语。

GPT-4的性能展示

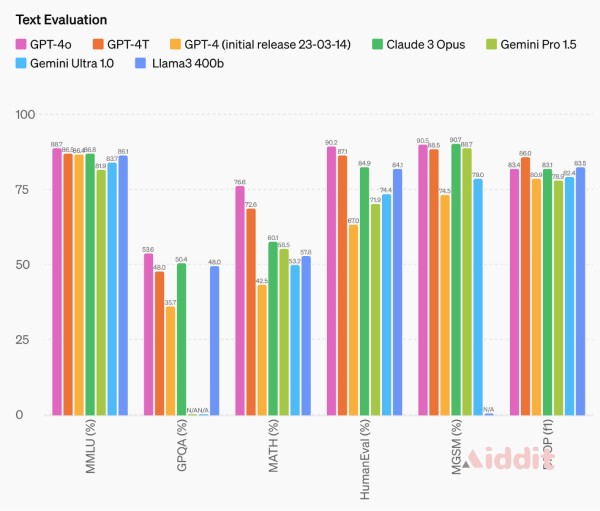

性能评估结果:GPT-4o在多语言理解均值(MMLU)基准测试中取得了87.2%的最高得分,在GPQA得分方面排名第一,达到53.6%;在MATH得分上也排名第一,得分为76.6%;在HumanEval得分中同样排名第一,得分为90.2%;在MGSM得分中排名第二,得分为90.5%(稍低于Claude 3 Opus)。这表明了它在推理智力和文本处理能力方面具有强大的表现。

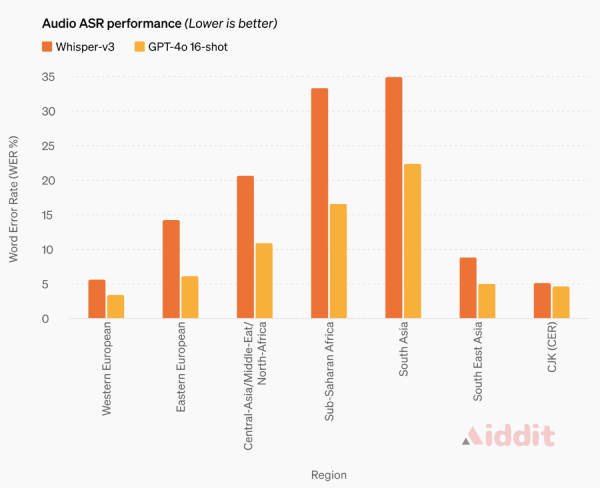

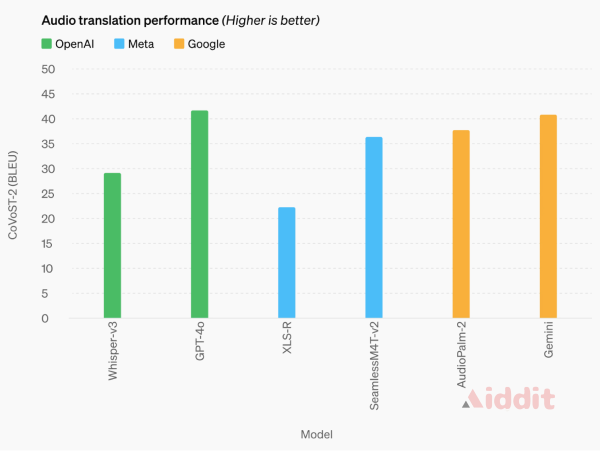

语音识别性能:相比于Whisper-v3,GPT-4o在所有语言上的表现都有显著提升,尤其是对于资源匮乏的语言。

声音转录表现:GPT-4o 在语音翻译方面达到了新的顶尖水平,在 MLS 基准测试中表现优异,超越了Whisper-v3、Meta的SeamlessM4T-v2和谷歌的Gemini。

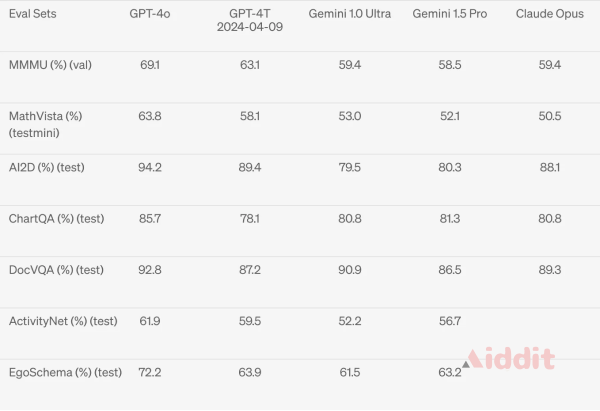

视觉理解测试:GPT-4o 在视觉感知基准测试中表现出最先进的性能,超过Gemini 1.0 Ultra、Gemini 1.5 Pro 和Claude 3 Opus。

GPT-4o和GPT-4 Turbo的区别

售价:GPT-4o的售价比GPT-4 Turbo便宜50%,具体来说,每百万输入标记的价格为5美元,每百万输出标记的价格为15美元。

速度限制:GPT-4o相较于GPT-4 Turbo提高了5倍的速度,每分钟可处理高达1000万个标记。

视觉能力:在评估和测试视觉能力时,GPT-4o的表现比GPT-4 Turbo更好。

多语言支持:GPT-4o 在非英语语言方面进行了改进,性能比GPT-4 Turbo更出色。

目前,GPT-4o的上下文窗口为128k,知识截止日期是2023年10月。

GPT-4o的使用方法

1. 准备数据:准备输入数据,包括文本、问题或任务描述等。

2. 调用API:使用适当的编程语言和GPT-4o的API连接到平台。

3. 发送请求:发送数据到GPT-4o,并等待响应。

4. 接收响应:收到GPT-4o生成的文本、答案或完成的任务。

5. 调整参数:根据需要调整模型参数或重复以上步骤。

GPT-4o的文本和图像功能正在逐步在ChatGPT中推出,用户可以在ChatGPT平台上免费尝试GPT-4o的相关功能,但免费版有次数限制。Plus用户的消息限制将是免费用户的5倍。

OpenAI计划在接下来的几周内发布Voice Mode的新版本,该版本将基于GPT-4o,并提供给ChatGPT Plus的Plus用户试用。此外,开发者也可以通过API获得GPT-4o,这个模型能处理文本和视觉数据。开发者可以将GPT-4o整合到他们的应用程序中,而且GPT-4o的API比GPT-4 Turbo更快、更便宜,速率限制也更高。

对于GPT-4o的音频和视频功能,OpenAI将在接下来的几周和几个月内持续完善技术基础设施、提升可用性以及确保安全性,待这些工作完成后再逐步向公众发布并提供这些功能。